出品 | 搜狐科技

作者 | 梁昌均

编辑 | 杨锦

距发布新一代Agent模型不到一个月,估值超30亿美元的AI独角兽——月之暗面,近日推出最新基座大模型Kimi K2。

这是一款具备更强代码能力、更擅长通用Agent任务的MoE架构基础模型,参数高达1T,也是1万亿,激活参数32B。

这是目前全球少有的万亿参数模型,也是目前唯一对外开源的万亿级参数模型。这也进一步表明,停止产品投流的月之暗面,回归大模型训练的技术路线。

Claude国产平替,性能超DeepSeek和通义

此次月之暗面发布了两个版本,Kimi-K2-Base未经过指令微调的基础预训练模型,适合科研与自定义场景;Kimi-K2-Instruct是经过后训练的通用对话与智能体模型,无需长时思考即可实现快速响应。

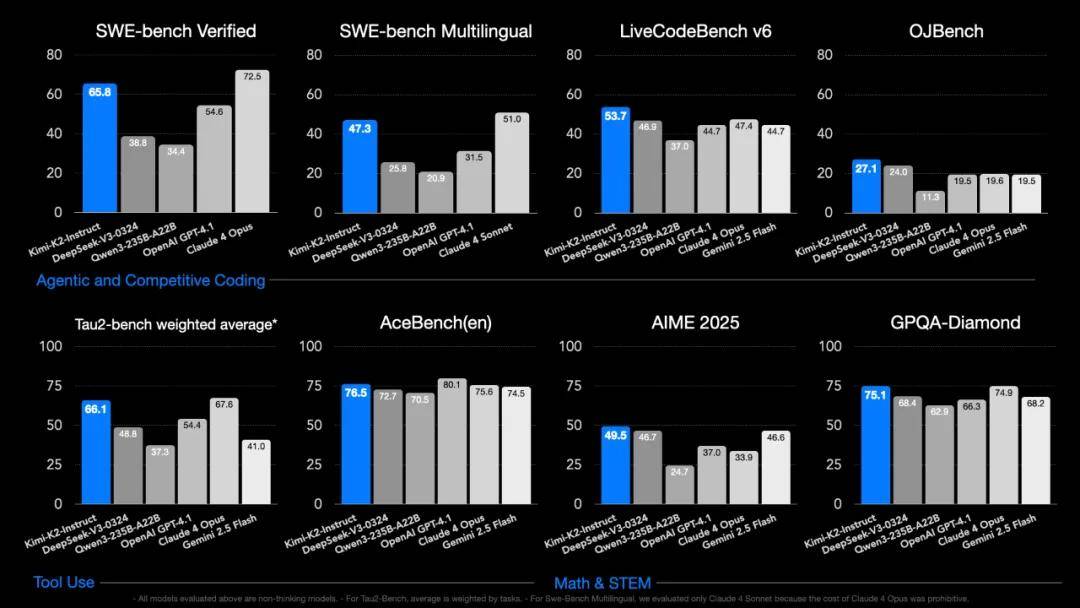

根据官方测评,Kimi K2在自主编程(Agentic Coding)、工具调用(Tool Use)和数学推理(Math & Reasoning)等三大能力维度的基准性能测试中取得优秀表现。

在SWE Bench Verified等编程和智能体测试中,Kimi K2的表现均超过DeepSeek-V3-0324、Qwen3-235B、GPT-4.1等模型,仅次于Claude 4 Opus,而在Livecode bench v6和OJBench测评中则超过前述所有模型和谷歌最新模型。

在Tau2、AceBench等工具调用测试中,Kimi K2在包括自身在内的六款对比模型排名第二,前者仅次于Claude 4 Opus,后者则不及GPT-4.1。在AIME 2025、GPAQ-Diamond等数学和复杂科学问题评测中,Kimi K2则均超过其它5款对比模型,取得最好成绩。

由于这是一款非推理模型,因此评测并未跟DeepSeek-R1、o3等推理模型进行对比。整体来看,Kimi K2已跻身开源阵营第一梯队,超过DeepSeek和阿里开源模型,同时接近海外领先的闭源模型,并在代码、Agent、数学推理任务上展现出突出能力。

比如,在前端开发任务中,Kimi K2 擅长生成兼具设计感与视觉表现力的代码,支持粒子系统、可视化和3D场景等表现形式,具备较强的图形能力与交互性。

“从Claude 3.5 Sonnet+开始,AI写前端到达了可以实用的程度,此后几乎所有新出的模型都会秀一下自己写前端的能力,Kimi K2当然也不能免俗。”参与Kimi K2研发的月之暗面工程师Justin Wong发文表示。

有开发者在体验后认为,Kimi K2性能处于Claude 3.5和Claude 4之间,UI生成很棒,而成本仅为 Claude 3.5的20%。“对大多数编码代理来说已经足够好,而且成本要可控得多。”

甚至有观点认为,Kimi K2有望成为Claude国产平替。美国大模型Anthropic公司推出的Claude模型被视为AI界的编码王者,因强大性能成为众多开发者、应用创业者的首选,Manus等很多Agent产品就构建在Claude基础之上。

美国AI搜索独角兽Perplexity AI的 CEO Aravind Srinivas就发文称月之暗面的新模型“令人难以置信”,并表示其在内部评估中看起来不错,因此可能很快就会开始对其进行后训练。

这款模型支持最长128K上下文,风格化写作能力也有所提升。月之暗面称,无论是用初中生语气改写科研文本,还是模仿苹果广告文案,都能保留原意与表达风格。

Kimi K2发布即开源,和DeepSeek均采取MIT开源协议,这意味着月之暗面选择加入开源阵营。“我们希望通过全面开源性能更强的模型,进一步加速AGI研究与应用落地的整体进程。”

Justin Wong解释称,选择开源,首先当然是想赚点名声。“如果是闭源服务,现在一定没有这么多关注和讨论,搞不好还会像Grok4一样明明做得很好却要承担不少苛责。”

其次,可以借助很多社区的力量完善技术生态。但更重要的是,开源意味着更高的技术标准,会倒逼我们做出更好的模型,与AGI的目标更一致。

“当开源要求你不能走捷径的时候,反而更有利做出更好的模型和产品。”Justin Wong说。

值得注意的是,此前预告要发布开源模型的OpenAI或因此跳票了。奥特曼表示,原计划本周发布开源模型,但因要进行额外的安全测试和审查而推迟。

摸着DeepSeek过河,杨植麟不想下牌桌

根据月之暗面目前发布的技术博客,Kimi K2性能的进步主要得益于三个方面的技术探索。

一是在预训练的算法创新。月之暗面透露,Kimi K2预训练阶段创新性地使用了Muon优化器,从而在15.5T token数据集上实现了万亿参数模型的稳定高效训练。

这抛弃了传统模型大规模使用的Adam优化器,Kimi K2利用Muon优化器,有效地防止了loss spike,即损失突刺现象。这主要出现在上百亿参数的大模型训练中,往往会导致模型无法收敛或训练失败。

OpenAI前首席科学家Ilya Sutskever曾表示,人类数据是有限的化石燃料,算力还在增长,但数据已经达到了峰值。

因此,月之暗面认为,在人类高质量数据成为瓶颈的背景下,预训练的token效率成为AI Scaling Law的新关键因素。

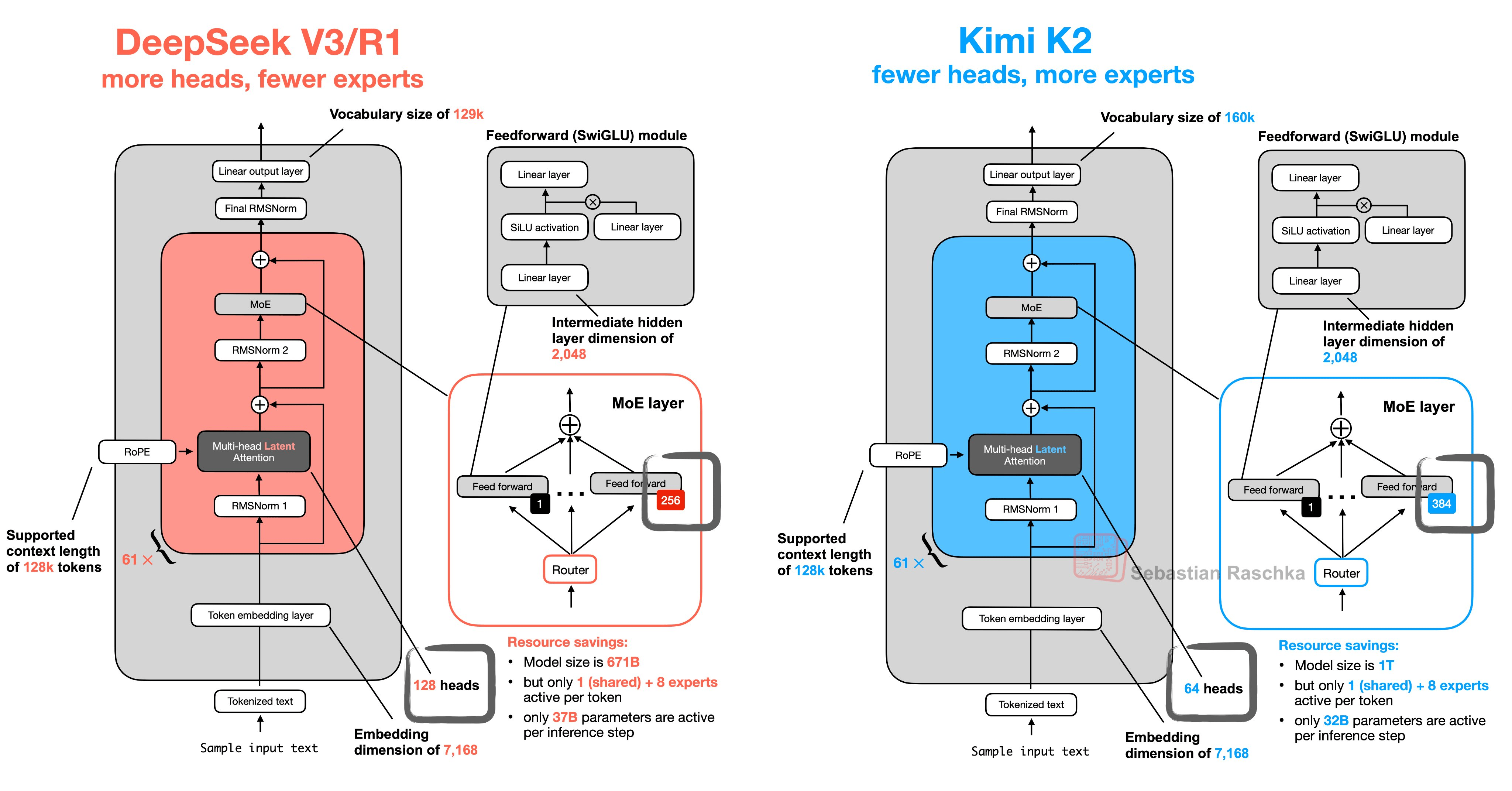

月之暗面还透露,Kimi K2采用了类似于DeepSeek-V3的架构。不少开发者也对比了两款模型的结构,发现颇为类似,比如均采取了MLA架构(多头潜在注意力机制),而在部分参数,主要是注意力机制中的头数(heads)和MoE中的专家(experts)数量方面进行了调整。

参与Kimi K2研发的月之暗面员工刘少伟表示,在启动K2训练前进行了大量模型结构相关的scaling实验,结果是当时所有架构没有一个能真正打败它,顶多旗鼓相当。

“我们要不要为了与DeepSeek不同,强行选择一个没有优势但不一样的结构,最终的答案是no。原因很简单:DeepSeek-V3的结构经过验证,在large scale上依然有效,而我们的新结构还并没有经历过足够大规模的验证。”因此,决定完全继承DeepSeek-V3的结构。

这背后也有成本考虑。刘少伟表示,小公司训练和推理资源非常有限,在DeepSeek-V3推出之后,月之暗面认为其训练和推理成本,都比较接近当前能承受的上限。“因此我们需要将K2的训练和推理成本,尽量控制在与DeepSeek-V3持平的水平。”

据了解,DeepSeek-V3训练成本为557.6万美元,训练过程使用2048块H800 GPU,总计消耗278.8万GPU小时,很大程度就得益于MLA(多头潜在注意力机制)等架构和算法创新。

可以说,月之暗面在摸着DeepSeek过河。不过,Kimi K2的API输入价格为4元/百万tokens,输出为16元/百万tokens,均为DeepSeek-V3模型价格的两倍。这或许显示出,Kimi K2的训推成本可能更高。

Justin Wong也提到了DeepSeek的影响。“DeepSeek-R1暴涨之后,很多人说kimi是不是不行了,你们是不是恨死DeepSeek了?恰恰相反,不少同事都认为DeepSeek-R1的爆火是个大好事,它证明了硬实力就是最好的推广,只要模型做的好,就会获得市场认可。”

他认为,DeepSeek证明了那条我们相信的路不仅能走通,而且是一条康庄大道。“唯一的遗憾就是:这条路不是我们走通的。”

Justin Wong还透露,在年初的反思会上,其提出了一些相当激进的建议,没想到植麟(注:月之暗面创始人)后续行动还要激进,比如不再更新K1系列模型,集中资源搞基础算法和K2,并在年初停止投流后坚持没有恢复投流。

第二个探索则是数据方面,通过大规模工具使用数据合成,月之暗面为Kimi K2构建了覆盖数百领域、数千工具的仿真管线,生成多轮交互场景并筛选出高质量的训练数据,从而为大规模无监督训练和强化学习铺平道路。

最后是在Kimi K2的后训练阶段使用了通用强化学习。针对可验证(如数学、竞赛编程)与不可验证(如研究报告撰写)任务,设计自评判机制,让模型同时作为执行者与批评者,利用可验证任务持续优化批评者,从而提升不可验证任务的奖励估计精度。

月之暗面强调,后训练在经验时代至关重要,可以让大模型通过自主生成交互学习,突破人类数据限制从而超越人类能力,这些正是Kimi K2的Agent能力提升的关键。

AI的经验时代是强化学习之父Richard Sutton提出的说法,其认为现在人类数据已达到极限,必须要让AI从人类经验中学习。

不过,月之暗面表示,Kimi K2当前还存在不少问题,比如复杂推理或工具定义模糊时可能生成冗余token,导致输出截断或工具调用不完整;启用工具后部分任务性能可能下降,以及单次提示构建完整软件项目的效果弱于智能体框架。

“Kimi K2是构建通用Agent能力的坚实基础,但通用Agent还需要更高级的能力。”月之暗面表示,未来将持续升级思维链与视觉理解能力。

Justin Wong认为,现阶段对模型Agent能力的开发还在早期,下一代预训练模型仍然大有可为。“2025年,智能的上限仍然完全由模型决定。”

如今,Kimi K2的发布,进一步印证了月之暗面想要留在大模型牌桌上的决心。

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏